January 19, 2026

Je medisch dossier inladen in nieuwe functie ChatGPT? Denk 10.000 keer na

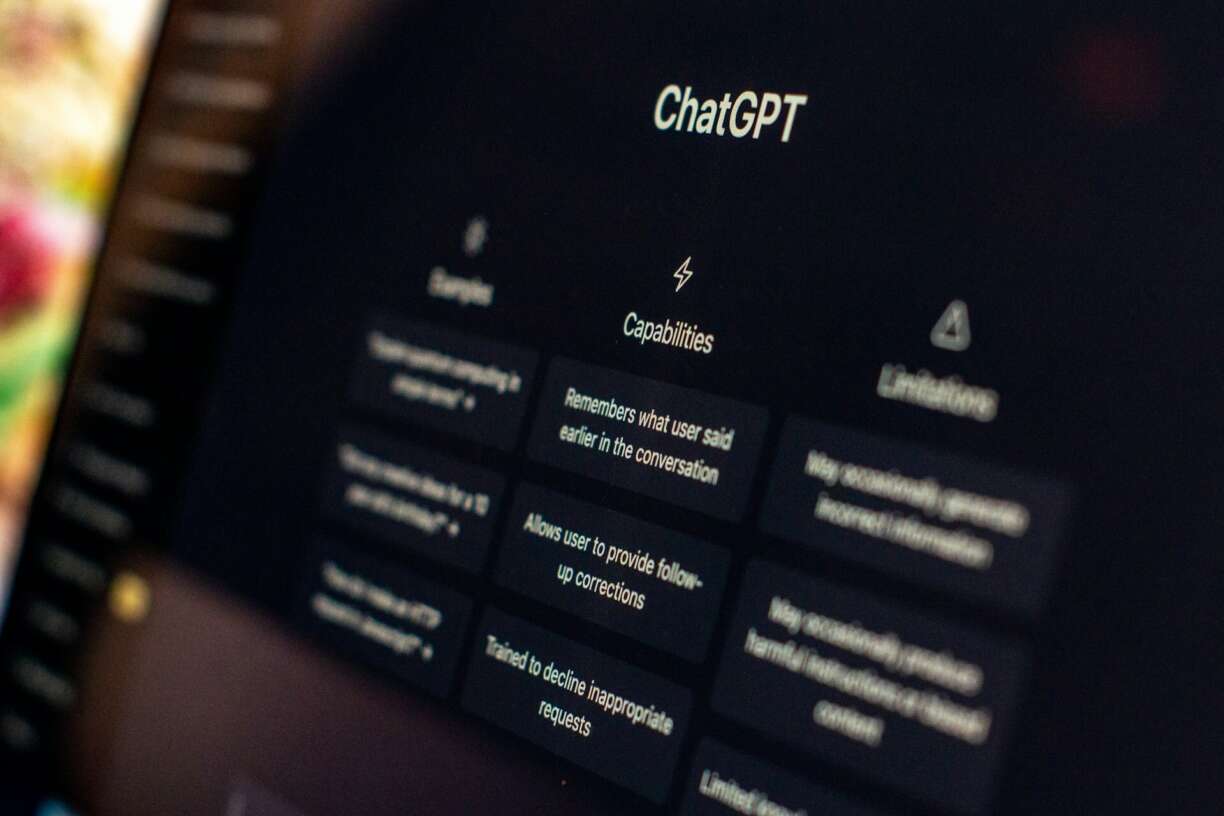

De AI-chatbot ChatGPT krijgt een speciale gezondheidsfunctie. Gebruikers kunnen dan onder meer hun medisch dossier uploaden om daarover vragen te stellen. Maar is dat wel verantwoord?

„De AI-healthmarkt is behoorlijk lucratief”, zegt Natali Helberger, universiteitshoogleraar recht en digitale technologie met een speciale focus op AI en privacy aan de Universiteit van Amsterdam. „ChatGPT Health is duidelijk bedoeld om een stevige greep op de markt te krijgen.”

ChatGPT, een toonaangevende AI-chatbot, kondigde vorige week de gezondheidsfunctie aan: ChatGPT Health. Volgens OpenAI, het bedrijf achter ChatGPT, brengt deze „gezondheid en de intelligentie van ChatGPT veilig samen”.

Volgens het bedrijf is gezondheid al een veelbesproken thema met de chatbot. „Honderden miljoenen mensen” zouden elke week vragen stellen over gezondheid en welzijn. De nieuwe gezondheidsfunctie biedt een aparte chatomgeving voor die behoefte. ChatGPT zegt dat die ruimte speciaal ontworpen is voor de gezondheidszorg. Mensen kunnen gezondheidsapps zoals Apple Health en bijvoorbeeld medische dossiers koppelen.

De introductie laat nog op zich wachten; gebruikers van de chatbot kunnen zich aanmelden voor een wachtlijst. In eerste instantie wordt de functie alleen in de Verenigde Staten uitgerold. Na verloop van tijd wil OpenAI die ook naar Europa brengen.

Delen

De stap van ChatGPT richting de gezondheidsmarkt is volgens universiteitshoogleraar Helberger niet raar. Het is namelijk niet nieuw dat mensen chatbots om gezondheidsadvies vragen, zegt ze. Toch „zet OpenAI het neer als een betere manier om gezondheidsdata te kunnen interpreteren en te bevragen. Health is interactief, je kunt ermee praten, dat is nieuw.”

Maar persoonlijke gezondheidsgegevens zoals in een medisch dossier zijn „heel gevoelig”, zegt Helberger. Daarom vindt ze het niet verstandig die in te laden in de chatbot. „Zulke informatie mag niet op straat komen te liggen.”

Het is namelijk een spanningsveld: gesprekken met een chatbot en ingevoerde informatie worden normaal gesproken gebruikt om de chatbot te trainen. Ook kan OpenAI persoonlijke informatie delen met derden. ChatGPT erkent echter dat gezondheidsgegevens van „gevoelige aard” zijn. Daarom zouden er voor de gezondheidsfunctie extra bescherming en een speciaal ontwikkelde versleuteling zijn. Ook worden gesprekken in ChatGPT Health volgens OpenAI niet gebruikt om de modellen te trainen.

Nadenken

Toch heeft Helberger flink wat kanttekeningen bij de verklaring van ChatGPT. „Ze adverteren dat extra zorgvuldig met de data in de gezondheidsfunctie wordt omgegaan”, zegt de privacydeskundige. „Maar ze zeggen ook veel dingen niet. Ze faciliteren bijvoorbeeld dat je Strava (app die sportprestaties bijhoudt, MS) kunt koppelen met ChatGPT Health. Wat ze niet vertellen is welke gegevens ze vervolgens met elkaar delen.”

Het is dan ook de vraag hoeveel de woorden van OpenAI over bewaarde privacy waard zijn. „Privacybeschermers zullen heel scherp meekijken hoe ver ChatGPT gaat met medische gegevens en wat het bedrijf ermee doet”, zegt Helberger. „Je moet hoe dan ook 10.000 keer nadenken of je die informatie deelt. De gegevens worden namelijk vaak in Amerika opgeslagen. De wetgeving is daar minder strikt dan bijvoorbeeld in Europa, waardoor er meer mag met de data.”

Helberger maakt zich ook zorgen over hoe ChatGPT zich opstelt in de gebruiksvoorwaarden. Daarin staat dat antwoorden van de chatbot niet gebruikt mogen worden voor medische beslissingen. Wie dat toch doet, handelt in strijd met de gebruiksvoorwaarden. „Het juridische gevolg is dat ChatGPT niet verantwoordelijk is voor de antwoorden, wat een arts wel is. Tot nu toe zijn die voorwaarden nog niet aangepast.”

Huisarts

Maartje Schermer, hoogleraar gezondheidsethiek in een technologische samenleving aan de Erasmus Universiteit Rotterdam, zet vooral vraagtekens bij de betrouwbaarheid van ChatGPT Health. Schermer is ook verbonden met de artsenfederatie KNMG. „We weten niet waar de gezondheids-AI op getraind is en hoe. Bovendien zijn taalmodellen zoals ChatGPT per definitie onbetrouwbaar. Ze voorspellen namelijk wat het meest voorspelbare volgende woord is. Er zullen dus altijd fouten in zitten. En in bijvoorbeeld een voorschrift voor medicijnen kan een nulletje te veel of te weinig het verschil tussen leven en dood zijn.”

Het kan voorkomen dat een patiënt thuis ChatGPT Health gaat raadplegen en daarna pas naar een huisarts gaat, weet de hoogleraar. Toch hoeft dat geen probleem te zijn, zegt ze. „Zolang de patiënt vertelt dat hij met een chatbot heeft gespard en wat daaruit is gekomen, kan de arts beoordelen of de informatie klopt of niet. Het is wel een probleem als de patiënt meer op ChatGPT dan op de arts vertrouwt. Of als hij niet tegen de dokter zegt dat hij met ChatGPT heeft gepraat.”

“Je weet niet wat er met je medische gegevens die je in ChatGPT deelt gedaan wordt. We moeten er enorm voorzichtig mee zijn.” — Natali Helberger

Voorzichtig

Zelf zegt OpenAI dat het model wordt getoetst aan „beoordelingscriteria die door artsen zijn opgesteld”. ChatGPT Health zou op die manier goed presteren, bijvoorbeeld bij „het uitleggen van laboratoriumresultaten in begrijpelijke taal” of „het voorbereiden van vragen voor een afspraak”. Het model zou bedoeld zijn om te ondersteunen, niet om zorgverleners te vervangen.

Maar ook daar is Helberger sceptisch over. „We weten dat in de praktijk veel mensen een advies van een chatbot serieus nemen. Vooral in landen als Amerika, waar toegang tot betaalbare zorg beperkt is voor veel mensen, speelt dat.”

Volgens Schermer is ChatGPT Health in Nederland geen uitkomst voor mensen die geen zorgkosten kunnen betalen. „Er is al betrouwbare medische informatie op internet te vinden, zoals op de website thuisarts.nl. Je hoeft dus helemaal niet naar ChatGPT. Voor Amerika geldt dat het ethisch een probleem is dat een systeem zo is ingericht dat mensen zonder geld geen arts kunnen raadplegen. Dan is ChatGPT niet de oplossing, maar moet het systeem anders worden.”

De functie om een medisch dossier in te voeren in de gezondheidsfunctie is vooralsnog alleen in Amerika beschikbaar. Maar het is niet ondenkbaar dat dit ook in Europa mogelijk wordt. „Maar het lijkt me erg dom om dat te doen”, zegt Schermer. „Je hebt geen idee waar die informatie blijft.”

Ook Helberger zou geen medische gegevens delen met ChatGPT. „Je weet niet wat ermee gedaan wordt. We moeten er enorm voorzichtig mee zijn.”

Dit artikel verscheen oorspronkelijk op Reformatorisch Dagblad op 16 januari 2026.

© Image: Unsplash/Emiliano Vittoriosi

More results /

Je medisch dossier inladen in nieuwe functie ChatGPT? Denk 10.000 keer na

Je medisch dossier inladen in nieuwe functie ChatGPT? Denk 10.000 keer na

By Natali Helberger • January 19, 2026

By Roel Dobbe • November 24, 2025

By Roel Dobbe • November 12, 2025

Combatting financial crime with AI at the crossroads of the revised EU AML/CFT regime and the AI Act

Combatting financial crime with AI at the crossroads of the revised EU AML/CFT regime and the AI Act

By Magdalena Brewczyńska • January 16, 2026

By Sabrina Kutscher • July 02, 2025

By Natali Helberger • March 06, 2025

By Maurits Kaptein • June 06, 2025

By Leonie Westerbeek • November 22, 2024

Clouded Judgments: Problematizing Cloud Infrastructures for News Media Companies

Clouded Judgments: Problematizing Cloud Infrastructures for News Media Companies

By Agustin Ferrari Braun • January 29, 2026

By Fabio Votta • November 05, 2025

By Ernesto de León • Fabio Votta • Theo Araujo • Claes de Vreese • October 28, 2025